AMD Instinct MI350 系列 GPU 发布, 35 倍推理性能提升

- 2025-07-05 19:35:23

- 764

IT之家6月13日消息,AMD在北京时间今日凌晨00:30举办了其年度人工智能直播活动AdvancingAI2025,AMD董事长兼首席执行官苏姿丰同其它高管以及AI生态系统合作伙伴、客户、开发人员一起,共同讨论了AMD的产品和软件如何重塑AI和高性能计算(HPC)格局。

在本次大会上,AMD展示了其全面的端到端集成人工智能平台愿景,并推出了全新基于行业标准的开放、可扩展的机架级人工智能基础设施产品。

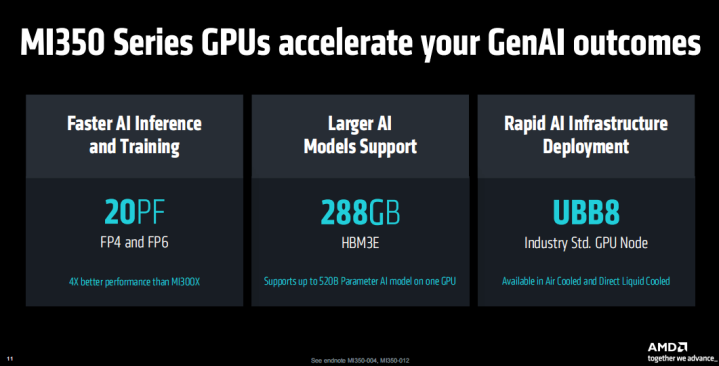

首先,AMD推出了全新一代InstinctMI350系列GPU,在生成式人工智能和高性能计算的性能、效率和可扩展性方面得到全面提升。

InstinctMI350系列包括InstinctMI350X和MI355XGPU及平台,实现了每代4倍的AI计算能力提升和35倍的推理性能飞跃。

新的GPU基于AMDCDNA4架构,3nm制程工艺打造,集成了1850亿个晶体管,支持FP4&FP6新一代AI数据类型,可提供288GBHBM3E显存,支持单GPU上运行高达520B参数的AI模型,支持UBB8行业标准GPU节点,提供风冷和直液冷两种版本,可以帮助企业实现快速部署基础设施。

AMDInstinctMI355XGPU在AI和HPC领域性能有出色表现,根据AMD的介绍,在与NVIDIAB200和GB200的对比中:

在内存容量方面,MI355X约为竞品的1.6倍,内存带宽则基本持平。

针对FP64和FP32运算,MI355X的峰值性能接近竞品的两倍。

对于FP16和FP8运算,其峰值性能与竞品相当或略高,FP6性能则达到2倍以上。

在FP4运算上,MI355X与竞品的峰值性能相近,小幅领先。

另外相比B200,使用InstinctMI355X可获得40%Tokens/$性价比提升。

而在和上一代MI300X的对比中,MI355X运行Llama3.1405B模型,在AI智能体性能表现上是前者的4.2倍,内容生成能力是上一代MI300X的2.9倍,摘要能力是上一代的3.8倍,对话式人工智能表现则为2.6倍。

AMD表示,InstinctMI350系列超出了AMD设定的五年目标,即将AI训练和高性能计算节点的能效提高30倍,最终实现了38倍的提升。

AMDInstinctMI350系列提供基于开放标准的机架基础设施和网络解决方案。

该系列产品支持UEC、OCP设计,搭载InstinctGPU与第五代EPYCx86CPU,不同配置包括128颗GPU、96颗GPU和64颗GPU,分别具备36TB、27TB和18TBHBM3E内存,性能指标涵盖FP8、FP6和FP4精度,适用于大规模机架扩展方案,预计从Q3开始通过AMD解决方案合作伙伴提供相关产品。

IT之家从活动获悉,AMD还预告了其下一代AI机架架构“Helios”。它将基于下一代AMDInstinctMI400系列GPU、基于“Zen6”架构的AMDEPYC“Venice”CPU以及AMDPensando“Vulcano”网卡构建。

同时AMD更预告了InstinctMI400系列GPU,预计2026年上市。该系列配备432GBHBM4显存,带宽达19.6TB/s,每GPU扩展带宽为300GB/s;提供40PFFP4和20PFFP8的AI计算性能,延续MI300X、MI325X等系列优势。

AMD还公布了一个新的2030年目标,即从2024年基准年起,将机架级能效提高20倍,届时,现在需要超过275个机架才能训练的典型AI模型,在2030年时仅需一个完全利用的机架即可完成训练,同时耗电量减少95%。

此外最新版本的AMD开源AI软件栈ROCm7也受到了不少网友的关注,其旨在满足生成式人工智能和高性能计算工作负载不断增长的需求——同时全面提升开发者体验。ROCm7具有改进的行业标准框架支持、扩展的硬件兼容性以及新的开发工具、驱动程序、API和库,以加速AI的开发和部署。

最后值得一提的是,AMD将为面向全球开发者和开源社区的AMD开发者云带来更广泛的使用权限。该平台专为快速、高性能的AI开发而构建,用户在AMD开发者云上将能够访问一个完全托管的云环境,包括拥有启动AI项目所需的工具和灵活性,并能够无限制扩展。

- 上一篇:安卓果里果气苹果卓里卓气

- 下一篇:块钱一碗的面被通报宴请